Содержимое сайта публикуется на условиях CreativeCommons Attribution-ShareAlike 3.0 или более поздней версии. Программные коды в тексте статей — на условиях GNU GPL v2 или более поздней версии.

Документация по совместной работе с репозиторием drupal.ru – https://docs.drupal.ru/code

Drupal – торговая марка Дриса Бёйтарта

12+

Модуль Rules Telegram (только Drupal 7)

Отличная идея, но у меня почему то не отрабатывает правило и сообщение в канал не отправляются. Посмотрел в журнале, пишет ошибку Illegal characters found in URL

Вывести описание термина таксономии в Facet Search страницу

Знаю что странная, но фильтрация магазина сделана для SEO через facets + pretypath +metatag facets. Категории, производители и еще несколько важных для поисковых запросов характеристики сделаны через таксономию выведенную в дальнейшем через фасеты. категория+ категория, как вы описали выше быть не может по настройкам, а вот категория+производитель+серия - да. В моей задаче нужно вывести описание, когда активен лишь один из фасетов, например категория, или производитель, что и усложняет задачу.

Вывести описание термина таксономии в Facet Search страницу

С Php все можно, интересно было условиями views задать

Вывести описание термина таксономии в Facet Search страницу

А как при этом настроить контекстные фильтры, которые определяли бы что этот фасет , отвечает за вот этот термин таксономии ? Taxonomy term id from url в данном случае не работает

Ищу приличный быстрый хостинг для проектов.

Ukraine, Timeweb, IT patrol

Мультимедиа. Как настроить стили изображений Gallery Formater для мобильной версии?

CSS пилите через media + max-width как сказали выше, не иначе

Оповещение о новых комментариях автора ноды в Rules

если с рулс не разберетесь можно модуль Comment notify использовать https://www.drupal.org/project/comment_notify

Права на папку постоянно сбрасываются на 555

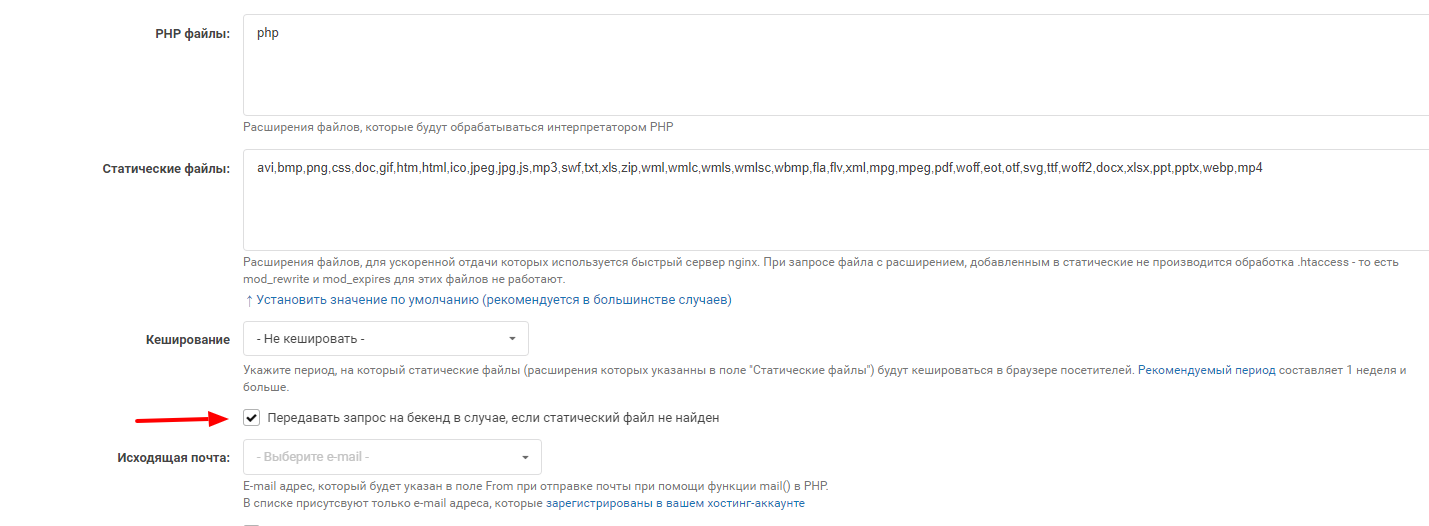

проблему с превью решил. Проблема в настройках хостинга, а именно в одной галочке, отвечающей за статические файлы:

Права на папку постоянно сбрасываются на 555

Пути к папке tmp пробовал по разному, и в корне сайта, и по предустановленным настройкам хостинга. Не помогает. Файл htaccess лежит, настройки php такие же, как и на других сайтах друпал которые лежать в этом аккаунте, только там все ок работает, а на этом сайте бог знает что.

Права на папку постоянно сбрасываются на 555

НЕ создаются превью стилей изображения, первым делом полез смотреть htaccess в default/files и заметил что хостинг ругается на то, что права на папку 555, а минимальные для правильной работы 750. Сайты на хостинге этом уже несколько лет лежат, раньше такого не замечал.

Права на папку постоянно сбрасываются на 555

И что делать ? С такими правами сайт не может корректно работать . Нужны 750!

Commerce 2 вопрос по мощности и сотням характеристикам товара

Согласен, абсолютно все характеристики делать словарями нет смысла

Commerce 2 вопрос по мощности и сотням характеристикам товара

Не нужно все термины характеристик делать в одном словаре. Создаете словарь Цвет - туда цвета добавляете, словарь Производитель - производителей и.т.д. Их будет много конечно, но это даст в будущем возможность эффективно продвигать сайт. Так, представим что нужно будет продвинуть запрос в будущем например: Наименование группы товаров+производитель+цвет, а у вас ввиду того, что категоризация сделана обычными текстовыми полями а не терминами, не будет такой страницы, со своими уникальными метаданными и ЧПУ.

Commerce 2 вопрос по мощности и сотням характеристикам товара

Таксономия лучше для фасетов тем, что их потом можно будет использовать для SEO. Facet Api + Facet API Pretty Paths +Metatag Taxonomy Facets = полно отличных посадочных страниц. С простыми полями так не сделаешь. А то потом когда после разработки доходит до SEO, оказывается что кроме страниц товара и продвигать то нечего, после различных решений разработчика.

Commerce 2 вопрос по мощности и сотням характеристикам товара

А какие типы полей ? Таксономия, текст ? Для фасетов сразу лучше на таксономии делать поля. Проблема с разными вариантами можно решить например создав не очередной тип товара, а поле (таксономия или выпадающий список) тип товара, которому привязать зависимость полей через модуль Conditional Fields. То есть, при выборе поля тип товара появляется один набор полей, при выборе другого - другой. Как вариант.

This request has been blocked; the content must be served over HTTPS

Возможно в htacess не верно редиректы прописаны на https, также желательно указывать в setting.php $base_url = 'https://вашдомен';

Подписка на новые материалы в Views + taxonomy facets

Нашел то что нужно, может кому тоже пригодится. https://www.drupal.org/project/search_api_saved_searches Правда тоже внешний вид и некоторый функционал стоит дорабатывать, но функционал выполняет!

Views Exposed Filter - выдает миллиард скрытых фильтров

Как вариант рассмотрите сменить фильтрацию с Exposed Filter на Search Api + Facet filters. Они и с SEO более дружелюбны, и проблема описанная вами уйдет.

Как считаете, насколько сеошник прав в составлении robots.txt ?

Вы так яро по все постам в этом разделе пошли комментарии оставлять, что сложилось впечатление, что Вы их даже не читали, лишь бы написать что. Прошу прощения если чем задел.

Как считаете, насколько сеошник прав в составлении robots.txt ?

Выше ведь написаны варианты, стоит просто почитать обсуждение, а потом только комментарии давать.

Как считаете, насколько сеошник прав в составлении robots.txt ?

Мда.. учиться Вам батенька еще и учиться. Не стоит комментировать все подряд посты только ради того, чтобы себе историю заработать, а то с самого начала себе репутацию не ту заработаете

Как считаете, насколько сеошник прав в составлении robots.txt ?

Может и достаточно будет, на усмотрение робота, но по рекомендациям того же Гула пагинацию желательно отмечать еще и next - prev. И ценность открытой пагинации не в том, чтобы ноды там индексировались (для этого сайтмап лучше использовать), а в передаче веса всех существующих страниц пагинации на главную страницу сайта\категории где представлена эта пагинация.

Шаблонизация тегов description к новостям в Drupal

Можно вставить как написали выше [node:summary] в настройках модуля metatag, а в типе материала, ограничить вывод анонса 150 символами ( [node:summary] выводит именно анонс материала)

Как считаете, насколько сеошник прав в составлении robots.txt ?

Ясно понятно. Читайте пожалуйста. Про мультисайтинг я вообще тогда лучше промолчу

Как считаете, насколько сеошник прав в составлении robots.txt ?

Не пишите ерунду и не вводите людей в заблуждение. Роботс для мультисайтинга можно настроить и без модуля (пример), a Host уже не используется поисковиками. Роботс указанный вами в примере мягко говоря не очень.

PS, Crawl-delay: 10 - это во первых дофига, во вторых ее тоже поисковики игнорируют уже из-за типичных неверных настроек юзерами.