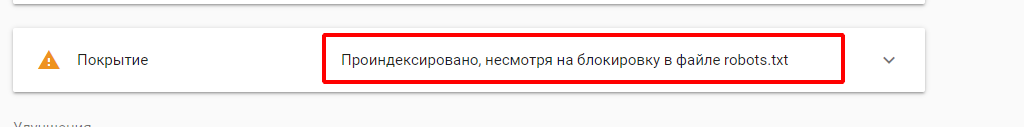

Всем привет. Не секрет, что при разработке и наполнении сайта волей не волей появляются технические дубли ( в т.ч. параметрические урлы, урлы переходов из facebook (site.com?fbclid), cloudflare (?__cf), и др.

Многие советуют закрывать в роботс. Однако роботс - это запрет сканирования, а не индексации. Если бот уже знает урл (например через api браузера он видит переходы), то закрытие в роботс не помогает убрать из индекса.

Вопрос: Есть ли решение для d9 для внедрения <meta name="robots" content="noindex"> по маске урла?

Нашел несколько модулей, однако они не прошли проверку безопасности:

noindex

robots_dtap

Комментарии

https://www.drupal.org/project/metatag/ подойдет?

Как в метатаг закрыть урлы в зависимости от параметра урл? Например example.com?__cf&double1&double2?

все, понял вам надо закрыть от индексации урл с запросом.

ставьте "желтый" модуль, если он вам подходит

Метатег предоставляет canonical. Этого достаточно.

С чего вы взяли? Скажите это консоли гугла, которая показывает индекс страниц. И плевать поисковики

хотели на ваш каноникал.

Читайте официальный ответ гугла:

Источник

Вы возводите в абсолют rel canonical, который может игнорироваться по огромному ряду причин. Например, Друпал из коробки использует canonical не правильно. А именно: страницы пагинации у движка каноникал, хотя страницы априори разные и по спецификации это никак не canonical.

К тому же я спрашиваю про исключение страницы из индекса, а не про присваивание значения canonical. Это принципиальные разные вещи.

Ох уж эти СЕО-нисты - сначала позакрывают от поисковиков страницы с utm-метками, а потом спрашивают, куда делась ссылочная масса)))

Хотя вам, безусловно, виднее. Я вообще атеист и не верю в сео))

Аргумент у вас от бога конечно. Что какие-то сеошники позакрывают какие-то utm-метки и потеряют ссылочную массу. Браво) Хотя речь идет о технической реализации noindex для управления индексом проекта.

Как можно делать сайты и не верить в СЕО?) СЕО разное бывает:

Так вот noindex - это строго техничка, которая должна быть реализована верно. Хотя вам то что, сделал сайт и пусть заказчик парится с ним сам.

Я делаю сайты, но не верю в СЕО (продвижение) это как вообще?) Или вас самое слово СЕО смущает?

Если у вас никогда не было проектов с большой посещаемостью, и вы всю жизнь просто делали средние интернет-магазины, то вы молчать должны в плане СЕО, и тем более не верить в то, чего никогда не делали и понять не можете что такое canonical, а что такое noindex и для чего они нужны.

Каноникал позволит гуглу понять, что страница с параметрическим хвостиком и без него - это одно и то же, и он в итоге их склеит, объединит вес и всё такое. Если же на параметрические ссылки повесить noindex, то гугл будет считать эти две страницы разными, но параметрическую из индекса уберёт. Как результат, все сторонние ссылки на ваш сайт, но с параметрами, просто не будут учитываться.

Я соглашусь с тем, что друпал по умолчанию в каноникал может насовать абы что, но это в 90% случаев легко решается прописыванием правильного токена в настройках метатегов. В остальных случаях это довольно просто правится кодом. Поэтому каноникал можно и нужно использовать.

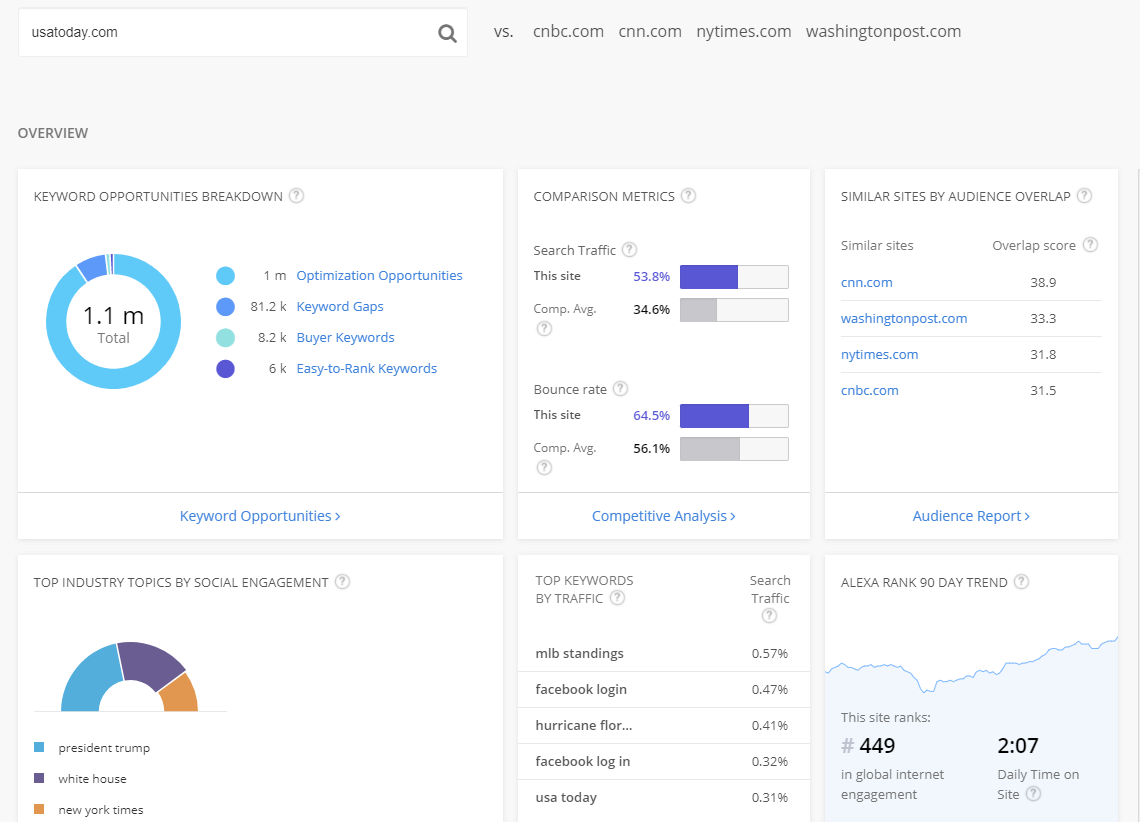

Что касается всяких онлайн-гиперов и порталов с большим посещением, там, очевидно тоже работают сео-атеисты. Возьмите любой сайт из топ-3 по любой распространённой тематике, там пэйджспид на мобиле будет не более 30, а скорее всего ниже 15. И всей этой сео-наркомании там тоже не будет. Просто вменяемые метатеги для нормальных сниппетов в поиске и соцсетях, плюс микроразметка, плюс всякие гугл амп и турбостраницы. И всё.

Я вам выше привел цитату из документации о том, что гугл по своему усмотрению использует каноникал. И если страницы попадают в индекс, и не склеиваются этим канониклом, значит их нужно закрывать. На них тратится бюджет обхода. Для больших проектов это критически важно.

Есть ваша теория о том, что гугл уберет эти дубли, а есть практика, где очевидно, что на самом деле это канониклом не решается.

Вы берете узкий пример и передергиваете. При чем здесь пейджспид вообще? Что СЕО слишком преувеличивают этот фактор? Давайте тогда будем клепать сайты с пейджспидом ниже 15? Если это сео-атеизм.

И да, для примера, ТОП сайты в мире:

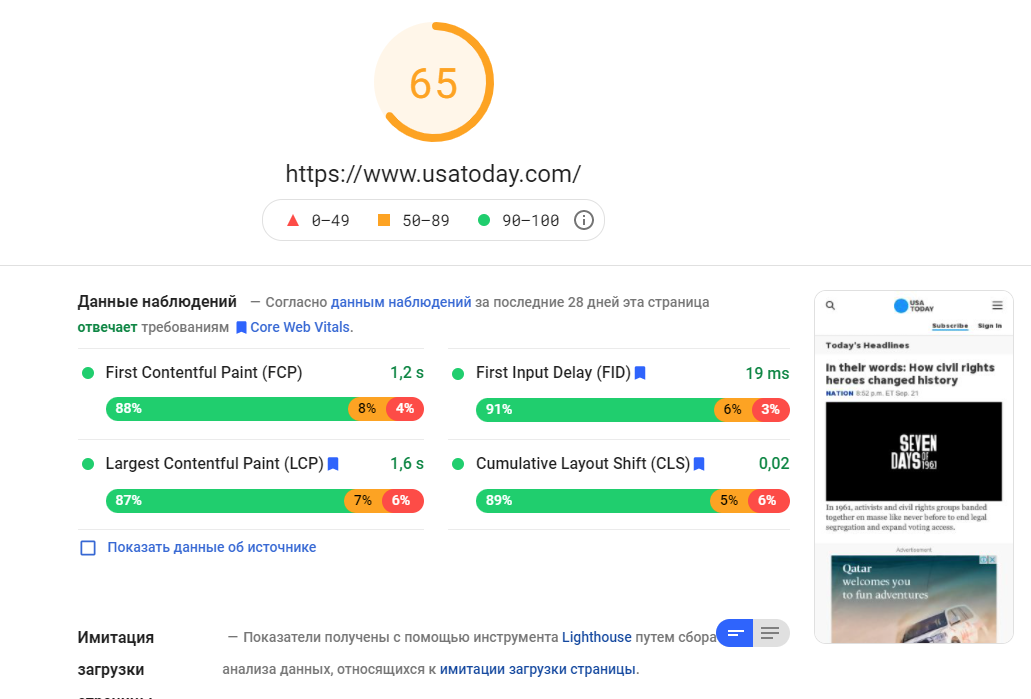

usatoday.com -

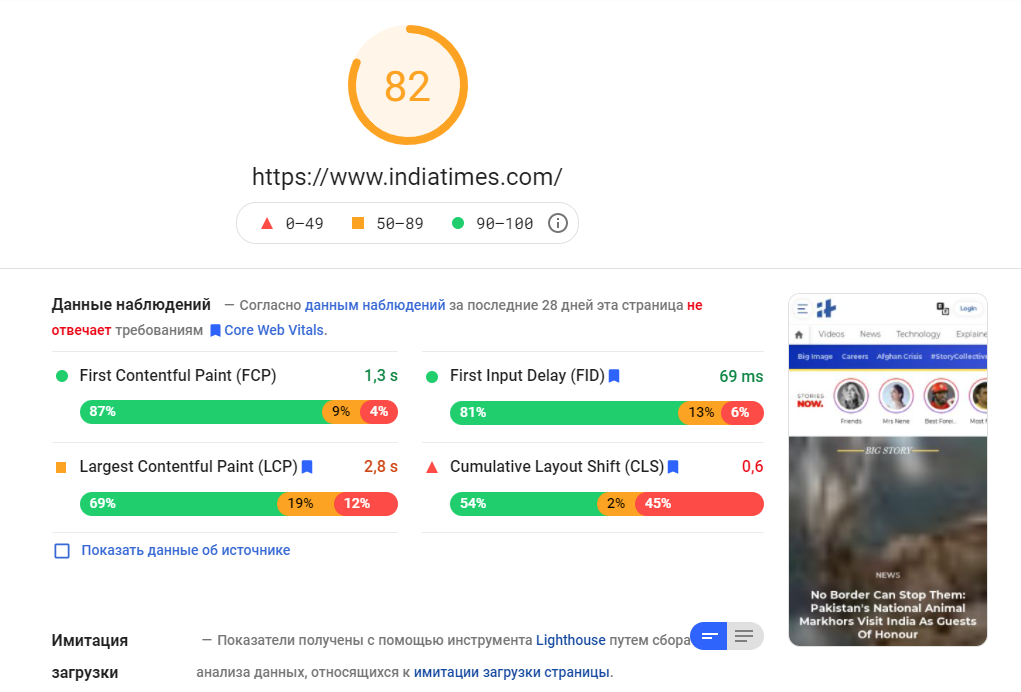

indiatimes.com -

Другие ТОП новостники тоже со временем подтянут скорость. И уж точно они не будут канониклом пытаться закрыть индекс). Более того, я убежден, что через пару лет проекты, имеющие пейджспид ниже 15 будет считаться моветоном, как когда-то отсутствие мобильной версии или адаптивной верстки.

Я повторюсь: если у вас нет опыта и вы никогда не вели проект-миллионник, вы не должны теоретизирвоать о том, что работает в сео, а что нет. Это все равно, что тренер в спортзале без бицухи подходит и продает свои персоналки) и всех учит как надо качать бицепс.

Проблема наоборот в том, что программисты теоретики толи в силу своего незнания, толи лени, полагаются на один лишь необязательный canonical и думают что самые умные, а все вокруг дураки.

Вы можете быть замечательным бэкендом, но когда дело дойдет до продвижения проекта, окажется, что СЕО был вовсе не атеизмом.

Поймите, что мир не черно-белый. В СЕО есть как шиза, так и технические параметры, которые нужно проверять и внедрять опытном путем. И только лишь на практике вы увидите как ведет себя поисковая система, которая умнее нас вместе взятых.

Ну ок, есть сайты с высоким пэйджспидом)) Но у ленты ру для мобил всего 28. Mvideo вообще 9. Я не говорю, что пэйджспид не нужен. Это как раз таки тот показатель, который нужно стараться держать на высоком уровне, но как показывает практика, плохой показатель не мешает выходить в топ выдачи.

Готов поспорить, что ни на одном из приведённых в примеры сайтах не отдают noindex на ссылки с параметрами, потому что это и есть самая настоящая сео-наркомания в чистом виде.

Прописал на всех страницах:

http://russkiyslovar.ru/d8/

Какую Маску Урла вы хотите?

Для всех страниц закрыть можно сотней способов.

Например с поддержкой регулярных выражений, или роутов.

Слишком общё. Как я это покажу?

Но прописать в сравнение адреса любое регулярное выражение - вообще не вижу проблемы.

Напишите Маску. Вы ведь изначально хотели Маску. А теперь уже - регулярные выражения

Маска - это недоделанное регулярное выражение.

А вы хотите Маску в виде регулярного выражения

Масленное недомасленное масло.

Просто задача мне кажется элементарной...

Сейчас сам придумаю маску.

http://russkiyslovar.ru/d8/node/4

http://russkiyslovar.ru/d8/node/6

Срабатывает только для Нод меньше 5

Задача решена. Тривиальна

Спасибо за идею, я думал, что есть контрибные модули, которые это делают, кроме тех, что не прошли секьюрити проверку.

Не стоит ориентироваться на "секьюрити проверку". Если модуль делает свою работу - это уже повод его использовать.

Просьба изучить мат часть, прежде чем писать глупости касательно параметрических урл и noindex.

1. Читайте про инструмент в search console по поводу управления сканированием параметрических урл (если страница отличается и если страница НЕ отличается) - https://www.google.com/webmasters/tools/crawl-url-parameters?utm_source=...

2. Читайте про директиву Clean-param: https://yandex.ru/support/webmaster/robot-workings/clean-param.html

Само наличие таких инструментов не наводит вас на мысль, что есть потребность управления параметрическими url?

Или вы считаете, что в крупнейших IT компаниях мира сидят "сео-наркоманы" и разрабатывают эти инструменты?

Был бы благодарен аргументированной информации, а не фразам вроде "сео-наркомания", "сео-атеизм" и пр.

Причем параметрические URL это был только лишь один из примеров применения noindex.

Я не просил показывать мне инструменты. Я просил показать какой-нибудь известный посещаемый сайт, который будет отдавать noindex на ссылку с параметрами и не будет ставить его, если пройти по этой же ссылке без параметров.

Касательно вашей проблемы с "жёлтыми" модулями, не прошедшими проверку безопасности. На любом сайте, помимо контрибных модулей всегда есть куча кастома. И вы думаете этот кастом кто-то проверяет на безопасность? Поэтому жёлтые модули можно смело ставить.

Например в издании theguardian, знаете такое?

это сделано через 301 редирект. Т.е все фейсбучные и пр. ссылки делают редирект на стороне сервера на ЧПУ урл:

https://www.theguardian.com/international/?fbclid=IwAR0NlvG1dzJhjU6SLdwE...

На разных проектах это реализовано по разному.

У меня есть опыт как использования 301, так и noindex на других проектах. И это прекрасно работает для управления индексацией крупного ресурса. Там критически важно, чтобы робот не тратил время на эти пустые url, а индексировал новые материалы.

Конкретно где noindex искать не буду потому, что времени доказывать человеку, который не воспринимает аргументы и не верит в те же параметрические url у меня нет.

Конкретно для Drupal я и ищу готовое решение.

Выше постили ссылки на готовые решения.

На том и решим. Просто я не в курсе по поводу "желтых" модулей.

Офигеть, чего вам понаписали "спецы".

Мне кажется, это полный идиотизм - отрицать ранжирование и следовательно SEO-продвижение.

Столько компаний ежемесячно вкидывают 500-1к $ в это направление (цифра актуальна для сферы услуг, в зависимости от региона и конкуренции). Тонны работы, проделанные с проектом и поведенческими факторами... и это не говоря о колоссальном, РУЧНОМ труде с контентом.

Ежемесячные встречи с владельцами бизнеса... Реальные кейсы веб-студии, в формате "было-стало".

А самый главный профит - в прибыли компании.

Брать пример из топ-сайтов - это вообще "абзац". Там, как минимум распиаренный бренд и/или рекламный бюджет, который измеряется с ВВП маленькой страны.

Ну кому всё это надо, это же так, для лохов. SEO-атеисты рулят

Ладно, без иронии, по делу:

Действительно, канноникал ничего не решит, если нет правила в роботс... Ибо страница всегда будет отдавать 200-статус. Затем она вылетит из индексации, как нерентабельная (не помню точное определение).

Disallow: /*?Этого правила достаточно в роботс и для Дру с ЧПУ... Ждете условный срок и больше запросы с get-параметрами не добавляются в обход и индекс. Могут быть нюансы, если проект специфический.

Кстати, рекомендую - https://www.drupal.org/project/robotstxt

Только, стандартный роботс из корня удалите, либо смотрите в статус ядра (там вам всё просигналит).

P.S. И да прибудет с вами пейджспид

Всем, кто наивно полагается на robots и canonical:

Автор пишет про ситуацию, когда не смотря на canonical, robots и прочие рекомендации гугла, он все равно лезет индексировать то, что не нужно. У меня тоже есть такие страницы, но их не много.

В этом случае делайте 301 редирект. И со временем робот склеит эти страницы и уберет из индекса мусор. Но когда таких страниц тысячи, на это может уйти пол года. Вы можете потерять траффик из-за множества малополезных страниц, которые учувствуют в ранжировании.

Google будет снова и снова индексировать этот мусор потому, что вы даже можете не подключать search console и не отправлять url на обход. Смотрите исходный код Google Chrome и как он через api отправляет эти url себе на индексацию не смотря на ваши robots и canonical.

Так, что проблема есть. Но вот как ее решить никто толом не понимает. Я за 301 редирект. Но на крайний случай можно и noindex прописать, если страницы явно мусорные и не должны показываться ни пользователю ни поисковым системам. И почему бы не дать такую возможность "из коробки", я не понимаю.

p.s. менеджеры из google и yandex прополоскали всем мозги о том, что их алгоритмы на столько умны, что все прекрасно понимают и там уже чуть ли не искусственный интеллект. А на деле, были бы алгоритмы так умны, то не нужна была микроразметка. Google часто не понимает даже где основной контент, а где aside. И слово из сайдбара вкупе с основным контентом для него считается поводом для ранжирвоания.